今から15年前の冬、 2002年12月を憶えていますか?あなたのカバンの中には、何が入っていましたか?

僕のダボダボのカバンの中には、大学ノートと、高校時代から同じ筆箱と、中古のWindows ノートPC(PC カードスロットにWi-Fi拡張カード)。クシャクシャになったバイト先の給与明細に、教科書やプリントの類。タバコは嫌いだったし、コーヒーもあまり好きじゃなかった。バイト帰り、工事中の小田急線のホームで、ノートPCのバッテリーが放つ微かなぬくもりを、逃さないように抱えていた―――

今、2017年12月、相変わらず工事中の小田急線のホーム、当時と変わらない寒さ、バッテリーのぬくもりを放つのは、手の中にあるスマートフォン(大量のプッシュ通知でロック画面が溢れている)、15年前のノートPCよりもずっと小さくて、ずっと高速で、バッテリー容量だって大きい。薄くなったカバンには契約書類とプレゼン資料、タバコに100円ライター、やっぱりクシャクシャの給与明細、ノートPCは当時と同じ大きさで、当時の何十倍も高性能で―――

15年前から、今の自分の姿を予期することは困難でした。それはひとりの人間の成長が重なるから、20代という、もしかしたら、もっとも変化に富んでいるであろう時期の。では、次の15年は?

テクノロジーの未来を考える時に、その技術分野は、人間に喩えれば何歳なのだろうと思うことがあります。本稿のテーマである音声対話技術分野については、おそらく、今、ほぼ生まれたばかりに等しいのではないでしょうか。そして、これから急速に、かつ非線形に成長して、今後の10年間で、最も華々しい時期を迎えます。15年後には既に社会に溶け込んでしまって、誰も敢えて着目するようなことではなくなるでしょう。

特に直近の5年間において、Voice User Interface(VUI)/Voice Personal Assistant(VPA)は、関連する諸分野を巻き込んで、私達の日常へと確実に浸透していきます。2020年までには全検索の半分が音声になると予測(※1)され、2021年には世界人口をVPA普及数が上回ると予測(※2)されています。

Figure 1: Digital assistant installed base by brand, 2015–21

Virtual digital assistants to overtake world population by 2021より引用

2017年12月の私たちは、コンピュータと人間との関わり方が根本から変わっていく変曲点、まさにその fundamental shiftの先端にいるのです―――

本稿では、このVUI/VPA関連技術に関する、私の観察と考察の一部をごく簡単に御紹介したいと思います。執筆時間の都合により、実際の応用製品・サービスについては紹介できなかった事例が多々あること、また、全体に渡り適切な図解を加えることができなかったことを最初にお詫びいたします。内容については、執筆時間の限り正確を期したつもりですが、誤字脱字・事実の誤認識などがありましたら、御指摘・ご指導を頂ければ幸いです。

文中に含まれる各社の商品名、サービス名は、各社の商標、または登録商標です。

生まれたてのヒゲオヤジ

音声認識技術発展の歴史、ごく大きく見ると、それは「ロバスト性向上の歴史」と言い換えることができるかもしれません。ロバスト性とはこの場合、実環境から得られる音声データの多様性に対して、認識器が、どれだけ頑健(ロバスト)に動作するか、ということです。それは例えば、こんな感じ。誰かの声は認識できても、誰かの声は認識できない。誰の声でも認識できるけど、マイクの近くで話さないと認識できない。誰の声でも認識できて、マイクから離れても、多少周りがうるさくても認識できるけど、同時に2人喋られると認識できない…。

音声認識技術は、1950年代に特定話者を対象とした単語認識器から始まりました。特定話者、つまり、誰かひとりの声に限ってしまえば、その多様性は、少なくとも不特定話者よりはずっと小さいもので、取り扱いやすいだろう、ということですね。

1960年代には当時の技術に基づく応用的なプロトタイプの、例えば音声タイプライターのような、構築は既に開始されており(※3)、音声波形パターンを、雛形の音声波形パターンと直接比較するような方式(※4)は1970年代には既によく知られ(※5、6)ていました。

しかしながら、不特定話者の声に対応していく上で、それらのテンプレートベースの手法では、声の多様性を適切にモデル化するには不十分だったようです。

当時のヒューリスティックなシステムを批判し、データ駆動型のアプローチへの転換を訴えたIBMの研究者が、1987年、とある米国の雑誌に寄せた印象的な寄稿文(※7)があります。

「機械に人間の真似をせよというのは間違ったアプローチです。つまるところは、機械が動くためには、足で歩くのではなく、タイヤを用いれば良いし、飛ぶためには、翼を羽ばたかせるのではなく、飛行機がしているようにすれば良い。人間がどのように言葉を認識し理解しているのか、そのルールをひたすら積み重ねるのではなく、機械にとってふさわしい方法で、それを与えてやればよいのです。その方法を私たちは見出していきたいと思っています。」

1980年代に入って、それまでよりも格段に量の多い(とはいえ現在の基準に照らせば「大量の」とまでは言えない)音声データに基づく確率的なモデル(GMM-HMM(※8), n-gram)を導入することで、多様性に対応するためのひとつの方法論が確立します。

それ以来20年以上に渡って、従来技術の改善や大規模な音声コーパスの応用が地味ながらも着実に進行することになります。この間、商業的応用も幅広く試行されています。しかしながら、実環境から得られる音声は、環境中の様々なノイズなどの影響を受け、さらに多様なものとなるため、実用的な認識精度が得られる場面は限定的であり、社会的には十分定着しない時代が長く続いていました。この頃開始された商業的応用の代表的事例として、大規模な音声データを基としたGMM-HMM型のモデルを利用した、みなさまもよくご存知のサービス、GOOG-411(※9)…ではなく、Google 音声検索が挙げられるでしょう。Google 音声検索では、検索窓に音声入力するという用途が絞られていて、その用途に対してデータ量が十分にあり、かつマイクの近傍で単独で発話するため環境ノイズの影響を受けにくい、こういった条件が揃ったことで、当時から実用に耐えうる認識精度が達成されていました。

2010年代に入り、DNNの登場によって、大語彙連続音声認識(※10)に遂にブレークスルーがもたらされます。従来のGMM-HMM型のモデルにおいて、GMMによる確率計算部分をDNNに置き換えたDNN-HMM型の認識器が登場し、現在も広く使われています。

これによって、さらなるロバスト性の向上がもたらされ、従来はマイクの近くで話さなければ正確に認識できなかったものが、多少マイクから距離が離れても何とかなるようになったり(遠隔発話)、自動車内などの騒音環境下でも認識率が維持できたりするようになってきています。

音声認識性能の向上は様々な実証データが示していますが、電話での会話という難しい状況において、人間とほぼ同等の誤認識率を達成したというIBMの成果(※11) や、2012年当時と比較し、誤認識率を30%削減したというGoogleの発表(※12)などが印象的です。

この理由をごく大きく捉えると、第一には、従来重要視されていた特徴量抽出処理の重要性が低下し、より「生の」音声情報を、従来よりも長い時間単位ごとにニューラルネットワークに導入することができるようになったこと(※13)が挙げられるでしょう。特徴量抽出処理というのは、御存知の通り諸刃の剣であり、物事をよりシンプルにモデル化するために有効である反面、単純化しすぎることで重要な情報を落としてしまうことがあります。そんなことって世の中よくありますよね、メガネを掛けないで鏡を見れば、なんか自分がイケメンになったような幻想を抱くことができるけど、メガネを掛けて良く見ると現実が分かるみたいな。

第二には、実環境で発生する様々なノイズ・残響などを学習データに混ぜて学習させること(データオーギュメンテーション)ができるようになってきた(※14)ということが挙げられるでしょう。従来はクリーンデータでのみ学習し、環境ノイズが存在する場合は、特殊な非線形処理(シングルチャネル・ノイズ抑制技術(※15))によって取り除き、擬似的にクリーンなデータを作る、というやり方が一般的でした。このようなやり方は現在ではオワコンになり、シングルチャネル・ノイズ抑制技術の重要度は大きく下がり、その代わりとして、バックエンド側に何らかの形でノイズロバスト性を持たせるやり方が主流となりました。

DNN-HMM型以外にも、さまざまなニューラルネットワークの構成が研究されています。それによって従来技術が置き換えられたり、従来技術の良いとこ取りが実現したり、さらなる性能向上がもたらされたりと、研究の最前線はダイナミックですが、本稿のスコープからは外れるので、最後に Andrew Ng先生の講義録(※16)を引いて、ここまでにしたいと思います。

“ A lot of people underestimate the difference between 95% and 99% accuracy in speech recognition. It’s the difference between you hardly using it and using it all the time without thinking about it. “ Andrew Ng

さて、2010年代前半には、iPhoneにSiriが搭載されています。国内では2009年に始まったGoogle音声検索のモバイル利用率は、2016年5月時点で、約20%と発表されており(※17)、冒頭に書いたように、2020年には全検索の50%が音声によると予測されています。

過去50年に渡って、人間はコンピュータとの関わり方を、繰り返しシンプル化してきました。パンチカードから始まり、キーボードへ、マウスからタッチへ、そしてついに最も自然で直感的な方法(※18)である「声」による操作へと急速にシフトしつつあります。DNNによる音声認識器の性能向上は、このための根幹的な要素技術となったと言えますが、そこに至るまでに、過去50年に渡る研究やプロトタイピングの歴史があり、まさに「生まれたてのヒゲオヤジ」のようなものであると言えるのではないでしょうか。

閑話休題、音声認識周りの事業を行っていると、たまに耳にするお客様の声として、「音声認識はもう枯れた技術で、イノベーションは無いよね?」とか「音声認識って人工知能じゃないよね?(※19)」とかがあります(※20)。これらに対してほぼ有意義なことは何も言えませんが、音声認識技術は、ヒゲオヤジ成分が強めであることの影響だろうと思っています。

さて、音声認識技術によって、声を文字に換えることはできました。では、文字にした後はどうなるのでしょうか?

どこで、誰に、何を、何のために?

音声対話の世界には、大きく分けて2つの世界があります。ひとつは「目的指向対話」の世界で、これは、機器の操作、路線検索や物品の購入など、対話に何らかの目的(ゴール)があるものです。ひとつは「非目的指向対話」の世界で、これは、ゴールがないもの、つまり雑談のことです。

文字にするだけで用が足りる音声認識の応用例もあります、その代表例は、一般的な捉え方では、例えば議事録作成システムなどでしょう(※21)。当初期の音声対話システムも文字にするだけで事実上用が足りていました。俗にコマンド&コントロールとも呼ばれることのある方式で、例えば;

ルール1「1チャンネルにして」

ルール2「音量下げて」

ルール3「テレビ消して」

・・・

のように、ひたすら音声コマンドと対応する制御を紐付けていく辞書を整備する方式です。組み込みデバイスなどでは、2017年現在もこの方式が利用されている製品は実際に存在します。それがリソース制限による限られた音声認識性能も含めて、どこで、誰に、どのような便益をもたらすのか、ちゃんと考えて作られた製品もあれば、そうではない製品も数多くあることは事実です。このような単純なパターンマッチは、1960年代に世界最初のチャットボットであるELIZA(※22)が登場したときの手法と大きく変わりません。

人間が頑張って、辞書やルールをひたすら積み重ねていく方式というのは、冒頭に紹介したIBM研究者の寄稿文を思い起こさせるものでもあり、数年前に話題になったApple Siri の対話シナリオライター求人募集(※23)を想起するものでもあります。Siri がユニークな回答を返してくれるのは、当たり前のことかもしれませんが、求人要項によれば “Excellent overall writing skill” を持つライターの台本によるものなのです。

コマンド&コントロールよりも複雑なシステムとして、現在の実用システムの多くでも採用されている方式は「スロットフィラー」と呼ばれる方式で、LISP言語での実装は1981年の文献(※24)で既に解説されています。

これは、例えば路線検索であれば;

ルール1「X から Y までの、路線検索して」

ルール2「X から Y までの、終電の時間を教えて」

ルール3「X から Z を経由して Y までどうやっていくの?」

・・・

というように、ルールの中に変数X、Y、Z(この場合は全て「駅名」)が埋め込まれたものです。発話テキストが、どのルールに当てはまるかを判定し、変数の中身を決定します。変数を埋めていくような動作からスロットフィラーと呼ばれています。ここで、発話揺れの吸収や、どのルールに当てはまるかの判定方法などでは、自然言語処理技術の長足の進化に伴って様々な改善がなされていますし、データに基づく既成スロットや、既成パターンの整備によって、従来よりも使いやすくなっていますが、大きくスロットフィラーという枠組みを転換するものではありません。具体的なスロットフィラーの使われ方については、例えば、Amazon Echo のスキル(アプリケーション)を開発するための解説ページ(※25)などを見れば明らかですので、本稿では省略します。

これらは主に目的指向対話のための技術であり、一般には意図理解技術と呼ばれることもあります。日本でも以前から研究・応用がなされていましたが、商用のチャットボットは、中国WeChat(※26)上でのチャットボットの成功を火元として、シリコンバレーに飛び火し、Amazon Echoの登場によって火の勢いはさらに増し、その後さらに日本に飛び火した結果、各社が様々な特徴ある技術を打ち出していますが、そういった製品の多くは、スロットフィラーのパラダイム、乱暴に言い換えてしまえばすなわち、一問一答のパラダイムから外れるものではありません。そこで達成可能な言語理解レベルは限られたものであり、人間のレベルと比較すると、まだまだ遠いものであることは直観的にもご理解頂けるかと思います。

そのように、限定的ながらも理解された発話意図に従ってシステムは動作し、動作した結果を自然文で返答する場合は、事前に設定されたシナリオに記載された通りの文章(から合成された音声)、もしくは何らかの固定的な基準で生成された文章(から合成された音声)が返されます。Siri に「結婚しよう?」と言った時、「実は他の人からも求婚されてるんです。」という返答は、そのようにシナリオに書かれているからで、「それ誰だよ?」と勢い込んでツッコミを入れた時、「なんのことだか分かりません」という逃げ(※27)は、前の質問の文脈を理解しての意図的なトボケではなく、単にシナリオでカバーしている範囲を超えてしまったことによる一種の異常系処理(※28)なのです。

ではスロットフィラーの次は何でしょうか?音声認識にはDNNによる分かりやすいブレークスルーがもたらされ、特定のタスクでは人間の誤認識率に迫っているのに対し、対話にはそのようなブレークスルーはもたらされていないのでしょうか?

残念ながら、少なくとも2017年12月現在、いまだ音声認識のような明らかなブレークスルーは、対話技術にはもたらされていないと考えています。

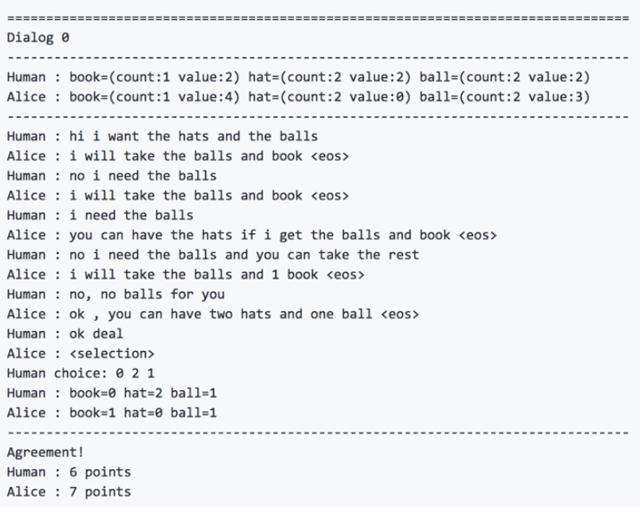

とはいえ、スロットフィラーの次のパラダイムを目指した研究や試行は活発です。その代表例は、Facebook の研究(※29)と、その実用先であるFacebook Messenger におけるパーソナルアシスタント「M」(※30)でしょう。Facebookは、スロットフィラーとは異なるパラダイムに基づく、先進的なチャットボットの研究においては世界最先端の一角であり、例えば、今年の6月に発表されたend-to-end negotiator(※31、32), は、人間と「交渉」が出来るチャットボットです。この研究では、最初にひとつの商品群(例えば、2冊の本と、1つの帽子と、3個のボール)が二者に提示されます。二者は、自然言語による「交渉」を通じて、この商品群を分けていきます。ここで両者にとって各商品の価値は異なるもので、それは相手方には開示されていないということがポイントになります。この詳細は、本稿の参照先をご覧頂くとして、ここでは、実際の「交渉」の様子を参照先のgithub から引用します。Aliceの方がボットです。

本はボットにとって価値が高く、帽子は人間にとっては価値が高い、という冒頭で示されている情報は、繰り返しになりますが、相手には開示されていないことに留意してください。

最初に人間は「帽子(2点)とボール(2点)」が欲しいと言います(本も同点ですが、本は1冊しかありません)。ボットは、「ボール(3点)と本(4点)が欲しい」と言います。帽子は0点なのでこの要求は当然でしょう。人間は「ボールは譲れない」と抵抗します。ボットは「もし僕にボールと本をくれたら、帽子はあなたにあげるよ?」と、なんと全く同じことを別の表現で繰り出してきます!そして最後には、ボットがボールのうち1個を人間に譲ってめでたく done deal、結果的に、二者にとってそれぞれ最適な分配が達成されました。

このシステムはシナリオのような人間が事前に与えたルールによって動作しているのではなく、交渉過程を学習することによってのみ動作しているというところが重要な点であると言えます。

声を文字にする性能の大幅な向上は、DNNがもたらしたブレークスルーそのものです。このブレークスルーの射程を的確に、過大評価も過小評価もせずに捉えた応用コンセプト(※33)は成功し、現在のスマートスピーカーを始めとしたVUI/VPAの初速がもたらされています。しかし、それ以上の知的な処理、つまり、発話内容を深く理解したり、何らかの推論を行ったり、人間にとって「自然な」対話を実現したりする部分については、上記の例のように、未だ研究途上の分野であって、分かりやすい性能向上を果たしていない分野です。DNNがもたらしたブレークスルーを過大評価し、この点まで踏み込んでしまった応用コンセプトは、事実上最初から失敗しているか、未来の可能性に賭けた挑戦的なプロジェクトのどちらかでしょう。

もちろん、上記のような研究の進展からも、一歩踏み込んだ応用コンセプトを持つ挑戦は、決して否定されるべきではないことが分かりますし、私自身は、冷静な現状認識に基づいた上で、積極的に新しい挑戦を行っていくべきであるという考えです。

しかしながら、現実には、挑戦可能な体制を持つ大組織が、縦割りの壁などに阻まれ、最初から挑戦することを諦めているとでも言うべき状況に出会ったり、逆に、全くトンチンカンな方向の取り組みに対して、そこそこの投資マネーが動いていたりする状況に出会うことも、残念ながら少なくはありません。

その技術、製品、サービスは、どこで、誰に、何を、何のために?自らの姿を、群像劇たるこの世界の中に冷静に位置づけた上で、その点から世界に自らの価値を問う。これらの点に集中すれば、挑戦するべきこと、挑戦するべきではないことの輪郭は、浮かび上がってくるのではないか思っています。

引き続き「音声対話技術の未来 後編」 をご覧ください。

補足・参考文献リスト

(※1)https://www.campaignlive.co.uk/article/just-say-it-future-search-voice-personal-digital-assistants/1392459

(※2)https://ovum.informa.com/resources/product-content/te0004-001165

(※3)T.Sakai and S.Doshita: "The Phonetic Typewriter" Proc. IFIP Congress 62, Munich, pp.445-450, 1962

(※4)パターン認識として捉えると、テンプレートベースの手法と捉えられる。

(※5)D. R. Reddy, L. D. Erman, R. D. Fennell and R. B. Neely, "The Hearsay-I Speech Understanding System: An Example of the Recognition Process," in IEEE Transactions on Computers, vol. C-25, no. 4, pp. 422-431, April 1976

(※6)H. Sakoe and S. Chiba, "Dynamic programming algorithm optimization for spoken word recognition," in IEEE Transactions on Acoustics, Speech, and Signal Processing, vol. 26, no. 1, pp. 43-49, Feb 1978.

(※7)http://www-03.ibm.com/ibm/history/ibm100/us/en/icons/speechreco/

(※8)https://www.gavo.t.u-tokyo.ac.jp/~mine/japanese/nlp+slp/HMM2DNN.pdf

(※9)https://en.wikipedia.org/wiki/GOOG-411

(※10)語彙や文法パターンを制約せず、連続的に音声を認識する技術。音声認識といって普通の人が普通に想像すると思われるもの。

(※11)George Saon, Gakuto Kurata, Tom Sercu, Kartik Audhkhasi, Samuel Thomas, Dimitrios Dimitriadis, Xiaodong Cui, Bhuvana Ramabhadran, Michael Picheny, Lynn-Li Lim, Bergul Roomi: “English Conversational Telephone Speech Recognition by Humans and Machines”, 2017; arXiv:1703.02136.

(※12)https://venturebeat.com/2017/01/11/google-has-slashed-its-speech-recognition-word-error-by-more-than-30-since-2012/

(※13)Peddinti, V., et al, “A time delay neural network architecture for efficient modeling of long temporal contexts." Proc. Interspeech (2015).

(※14)Awni Hannun, Carl Case, Jared Casper, Bryan Catanzaro, Greg Diamos, Erich Elsen, Ryan Prenger, Sanjeev Satheesh, Shubho Sengupta, Adam Coates: “Deep Speech: Scaling up end-to-end speech recognition”, 2014; http://arxiv.org/abs/1412.5567 arXiv:1412.5567

(※15)シングルチャネルのノイズ抑制技術です。多チャンネルではないことに留意してください。

(※16)https://www.contagious.com/blogs/news-and-views/akqa-bedtime-story-sounds

(※17)http://apac.thinkwithgoogle.com/intl/ja_all/articles/gmn-takeaways2017.html

(※18)当然、あらゆる場面で声による操作が最適であるということではありません。リモコンのボタンを押した方が明らかに早いことや、GUIによる一覧が最適であることなど。適材適所。

(※19)おそらく何らかの哲学的かつ深遠な質問であると思われるため…

(※20)さすがにここ1年くらいはメディアの影響でこういった話が出ることはほぼなくなってきましたが…

(※21)私自身の捉え方は異なりますが、本稿のテーマから外れるので省略します。

(※22)https://ja.wikipedia.org/wiki/ELIZA

(※23)https://www.forbes.com/sites/timworstall/2013/01/19/what-a-great-job-writing-the-scripts-for-apples-siri/

(※24)As presented by Roger C. Schank and Christopher K. Riesbeck in Inside Computer Understanding: Five Programs Plus Miniatures, Lawrence Erlbaum Associates, 1981.

(※25)https://developer.amazon.com/ja/docs/ask-overviews/build-skills-with-the-alexa-skills-kit.html

(※26)https://chatbotsmagazine.com/china-wechat-and-the-origins-of-chatbots-89c481f15a44

(※27)羨ましい限りですがSiri はモテるという設定なのでしょう。それは意外と笑い話ではなく、継続的に使用されるVPAはモテるようです、本当に。

(※28)どこまでがシナリオのカバー範囲なのか、厳密には、外からは計り知れませんが…。それがSiriの面白さのひとつの要因なのかもしれません。

(※29)Mike Lewis, Denis Yarats, Yann N. Dauphin, Devi Parikh: “Deal or No Deal? End-to-End Learning for Negotiation Dialogues”, 2017; [http://arxiv.org/abs/1706.05125 arXiv:1706.05125].

(※30)https://techcrunch.com/2017/06/27/facebook-improves-its-ai-messenger-assistant-m-with-new-wits/

(※31)https://github.com/facebookresearch/end-to-end-negotiator

(※32)https://code.facebook.com/posts/1686672014972296/deal-or-no-deal-training-ai-bots-to-negotiate/

(※33)Google 音声検索は言うまでもなく、Amazon Echo のキャッチコピー「Just Ask Alexa(Alexaに聞いてみよう)」も、一問一答を積極的に誘導するコピーであると考えられるのではないでしょうか。

藤野 真人

フェアリーデバイセズ株式会社 代表取締役

1981年埼玉県生まれ。2005年東京大学農学部生物情報工学研究室卒業、2007年東京大学大学院医学系研究科医科学専攻退学。 東京大学在学中に大学発創薬ベンチャー企業の創業メンバー(研究開発担当)として立ち上げに参画。同大学院医学系研究科に進学する傍ら、同社経営体制の変更に伴い代表取締役に就任するも、大学院課程での実習中の経験から「人の心に寄り添うモノの温かさ」に気付き、大学院を中退し、自ら起業することを決意。「使う人の心を温かくする一助となる技術開発」をテーマに、フェアリーデバイセズ株式会社を2007年設立。2009年「センサーデバイスを用いた弦楽器の自律演奏」が未踏に採択される。非公式の未踏PM勝手連より「スーパーチャレンジャー認定」を授与される。